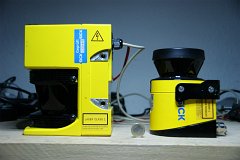

Um mal wieder ein klein wenig handwerkliche Arbeiten zu machen, wurde die Kinect-Kamera für eine spätere Montage auf dem Roboter vorbereitet. Da sicher viele sich schon überlegt haben, wie man diese Kamera montieren könnte, hier eine mögliche Lösung dazu.

Als erstes wurde der Fuß der Kamera geöffnet. Hierzu wird die gummierte Seite vorsichtig abgezogen. Vorsichtig deshalb, weil sie später wieder aufgeklebt wird. Unterhalb der Gummiabdeckung befinden sich 4 kleine Torx-Schrauben, die sich aber zur Not auch mit einem Schlitzschraubendreher entfernen lassen. Das sieht dann geöffnet so aus:

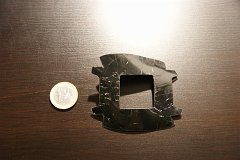

Hier die Gummiabdeckung:

In den Fuß der Kinect-Kamera sollen nun 3mm "Gewinde" verbaut werden. Damit die Torx-Schrauben leichter eingesetzt werden können, wird die entfernte Gummiabdeckung wie abgebildet eingeschnitten. Und zwar genau an den Stellen, wo die kreisrunden Abdrücke im Gummi zu sehen sind. Ruhig grob ausschneiden. Bohren in das dünne Gummi hat nicht gut funktioniert, darum einfach per Saitenschneider oder Cutter das Material entfernen:

Nun die Kunststoffabdeckung fest aber vorsichtig einspannen und mit einem 3 mm-Bohrer drei Löcher in die gekennzeichneten Stellen bohren (die Stelle beim Metallbügel nicht durchbohren):

Danach die überstehenden Rest vorsichtig(!) mit einem großen Bohrer herunter bohren, damit es danach so aussieht:

Nun das Gummi wieder aufkleben:

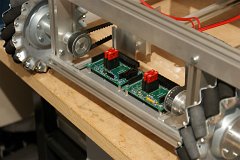

Als nächstes drei 3mm-Schrauben von der Unterseite (Gummiseite) durch die Löcher stecken, mit Muttern von innen verschrauben und leicht anziehen:

Nun der entscheidende Teil, von dem leider kein Foto vorhanden ist. In dieser Position, wie das Teil auf dem letzten Foto liegt, Heißkleber vorsichtig über die Muttern (mit den durchgesteckten Schrauben laufen lassen. Hierbei gut darauf achten, dass der Kleber 1. möglichst nur in die Kammer rund um die Mutter läuft und 2. möglichst keine Lufteinschlüsse innerhalb des Heißklebers sind.

Den Kleber ausreichend abkühlen lassen (im Idealfall über Nacht) und danach ggf. überstehende Reste mir einem Cutter vorsichtig entfernen. Das Ergebnis sieht dann hoffentlich so aus:

Wenn man die Schrauebn nun vorsichtig heraus dreht, sieht man *tadah* die neuen Gewinde im Fuß der Kinect-Kamera:

Und hier das Gesamtergebnis (mit einer Schraube). Viel Spaß beim Basteln:

Die hier gezeigte Anleitung führt zum Verlust der Garantie der Kamera und erfolgt auf eigene Gefahr!